Werkstattblick:

NLP und Chat-GPT im Customer Support richtig nutzen

Werkstattblick:

NLP & Chat-GPT

im Customer Support richtig nutzen

Vom Preprocessing bis zur Integration von GPT-3: Ein Erfahrungsbericht vom PLAN D Technologieteam

Chat GPT beflügelt die Fantasie vieler Manager:innen. Jedes sechste Unternehmen in Deutschland plant den Einsatz von KI zur Textgenerierung. Doch noch befinden wir uns in einer Phase der Experimente, des individuellen Ausprobierens. Offiziell sind Natural Language Processing (NLP) und große Sprachmodelle noch selten im Einsatz.

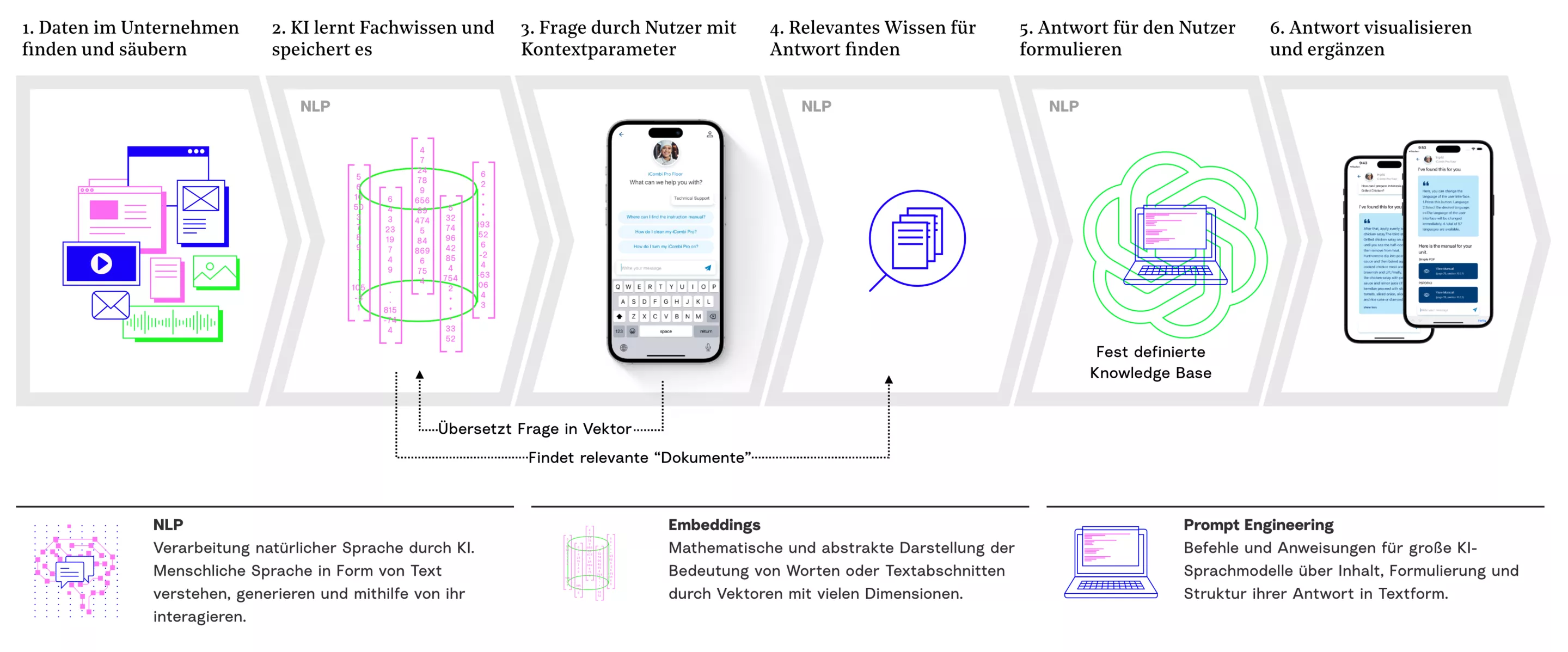

Das könnte sich bald ändern: Anfang des Jahres haben wir ChatGPT erstmals in ein eigenes KI-Projekt integriert. Für den Kundenservice des Küchenherstellers RATIONAL entwickelten wir eine KI-basierte Anwendung, die Informationen aus Anleitungen und Rezepten ausgibt. Um den Dialog so angenehm wie möglich zu gestalten, integrierten wir die API von ChatGPT.

Wollen auch Sie das Fachwissen Ihres Unternehmens mit der Redegewandtheit des großen Sprachmodells verbinden? Dann lesen Sie weiter und schauen Sie hinter die Kulissen des Projekts. Unsere Data Scientists führen Sie durch alle technischen Prozessschritte und erklären, was es bei der Integration von ChatGPT zu beachten gilt.

„Wir haben das Gedächtnis der

KI erschaffen“

„Wir haben das

Gedächtnis der KI

erschaffen“

Florian Titze, Junior Data Scientist, war für das Aufsetzen der Datenbank und das Preprocessing der Daten zuständig. Dabei stellte er sich unter anderem folgende Fragen:

Welche Daten haben wir?

Das Aufsetzen der Datenbank war – wie in vielen anderen Projekten – auch in diesem Projekt eine besondere Herausforderung. Denn die Informationen, die für die Beantwortung der Kundenfragen relevant sind, lagen verstreut in unterschiedlichsten Quellen: Websites, PDF-Dokumente, Tabellen… Umso befriedigender war es, als am Ende eine strukturierte Datenbank entstand, die uns als Basis für die NLP-Pipeline diente. Wir haben sozusagen das Gedächtnis der künstlichen Intelligenz erschaffen – mit allem, was sie über die Bedienung der RATIONAL-Küchengeräte und die Zubereitung von Speisen wissen muss.

Welche Frameworks und Tools eignen sich?

Beim Aufbau der Datenbank und Preprocessing konnten wir auf Technologien zurückgreifen, mit denen wir bereits in früheren Projekten gute Erfahrungen gesammelt hatten:

- PostgreSQL: Das objektrelationale Datenbankmanagement-System ist zuverlässig und benutzerfreundlich.

- Mit Soda testeten wir die Qualität und Verlässlichkeit unserer Daten.

Im nächsten Schritt ging es darum, ein Framework zum Aufsetzen der NLP-Pipeline auszuwählen. Große und komplexe Modelle auf Basis riesiger Datenmengen haben wir dabei bewusst vermieden, da sie für unseren konkreten Fall ein „Overkill“ gewesen wären. So fiel die Wahl auf das Open-Source-Framework Haystack.

“Man muss

Chat-GPT klare

Anweisungen geben“

“Man muss Chat-GPT klare Anweisungen geben“

Yannic Spreen-Ledebur, Junior Data Scientist, setzte die NLP-Pipeline auf und integrierte GPT-3 in unsere Anwendung.

Welche NLP-Technologie ist die Richtige?

Haystack war für uns die perfekte Umgebung, um verschiedene NLP-Ansätze auszuprobieren. Reichte eine reine Dokumentensuche, bei der die relevantesten Dokumente ausgegeben werden? Oder sollte die Anwendung eigene Antworten formulieren?

Da die Anrufer:innen des Kundensupports von RATIONAL eher nach präzisen Antworten als nach langen Gesprächen suchen, entschieden wir uns für die Ausgabe von Textauszügen aus den relevantesten Dokumenten. Diese Vorgehensweise wird auch als „information retrieval“ bezeichnet. Da unsere Textpassagen während des Preprocessings in kleinere Passagen geteilt wurden, eigneten sich diese als Ausgabe-Format.

Wie lässt sich Chat-GPT integrieren?

Unser Projekt fand in einer Zeit statt, in der der Hype um ChatGPT auf einem Höhepunkt war. So wurden wir neugierig: Was wäre, wenn wir uns die Fähigkeiten des großen Sprachmodells zunutze machen könnten?

Mit dem Ziel, ohne großen Aufwand eine generative Q&A-Pipeline aufzubauen – d.h. schöne Antworten zu formulieren – integrierten wir die API von GPT-3 in unsere Anwendung. So verbindet der Chatbot das Fachwissen von RATIONAL mit der Eloquenz des Large Language Models.

Das Fazit: Es geht! Auf zwei Dinge sollte man allerdings achten:

- Halluzinationen: Die Informationen, die ChatGPT ausgibt, sind perfekt formuliert – aber nicht immer korrekt. Dieses Problem haben wir gelöst, indem wir dem Chatbot zu Beginn klare Anweisungen wie diese gaben. “I am a highly intelligent question answering bot specialized on device manual information for the Rational kitchen device <DEVICE>.”

- Format-Zufälle: Um die Kontrolle über das Ausgabe-Format zu behalten, haben wir ein Gold-Beispiel mitgeliefert. Dank einer Beispiel-Frage, Beispiel-Dokumenten und einer Beispiel-Antwort weiß der Chatbot genau, was von ihm erwartet wird.

„Die KI hat keinen Zugriff auf die Originaldaten“

Raana Saheb Nassagh, Data Scientist, war dafür verantwortlich, eine sichere und nachhaltige Infrastruktur bereitzustellen.

Wie schützen wir personenbezogene Daten?

Beim Aufsetzen der Schnittstellen, Docker-Container und Datenbanken galt es zahlreiche Fragen zu klären. Wie sorgen wir für eine sichere Kommunikation zwischen Webapp und Chatbot? Was müssen wir beachten, um später auch andere Datenformate wie Bilder und Videos unterstützen zu können?

Besonders wichtig war für uns die Frage des Datenschutzes. Denn unsere Datenbank könnte mittelfristig auch personenbezogene Daten wie E-Mail-Adressen enthalten. Um sicherzugehen, dass die KI-Modelle keinen Zugriff darauf haben, stellten wir zwei unterschiedliche Server bereit: Auf einem Server liegen die „Originaldaten“, auf die niemand von außen zugreifen kann. Auf dem anderen Server liegen die anonymisierten Daten, die auch vom Docker-Container des Chatbots erreichbar sind.

Welche Technologien kamen zum Einsatz?

Neben den bereits genannten Tools zur Datenverarbeitung haben wir mit folgenden Technologien gearbeitet:

- Portainer für ein einfaches Hosting und Deployment der Docker-Container

- Fast API, um Endpunkte für den Chatbot zu definieren und Requests einfacher validieren zu können

- AWS Cloud + Festplattenverschlüsselung als sichere Umgebung für unsere Datenbank

- Pytest, um Requests zum Server simulieren bzw. testen können

- Gitlab Runner für automatische Tests und Code Checks vor einem Deployment

„Chat-GPT ist nur ein Baustein von vielen“

Dr. Alexander Friedenberger leitet das Team Data Science. Hier zieht er ein Fazit aus dem erfolgreichen Projekt.

KI hilft gegen den Fachkräftemangel

Ich bin beeindruckt, was unser Data Team geleistet hat. In nur 100 Tagen haben sie das Fachwissen von RATIONAL digitalisiert und dauerhaft nutzbar gemacht. Schon bald könnten viele Standardanliegen durch den digitalen Kollegen der ChefLine geklärt werden. Auf diese Weise kann der Chatbot zu einer spürbaren Entlastung im Kundensupport beitragen – und fehlende Fachkräfte ersetzen.

Ich bin mir sicher: Die kluge Kombination aus eigener Dokumentensuche und der Einbindung von ChatGPT lässt sich auf viele Unternehmen übertragen. In Zeiten eines massiven Fachkräftemangels ist das eine gute Nachricht.

Chat-GPT lässt sich datenschutzkonform

einbinden

Chat-GPT lässt sich datenschutzkonform einbinden

Die zweite gute Nachricht: Das Ganze funktioniert, ohne die personenbezogenen Daten von Kund:innen und Mitarbeiter:innen preiszugeben. Dank der separaten Speicherung der Originaldaten muss sich RATIONAL keine Sorgen darüber machen, dass das Sprachmodell von OpenAI auf sensible Daten zugreifen könnte.

NLP in Unternehmen: GPT-3 ist ein Baustein von

vielen

NLP in Unternehmen: GPT-3 ist ein Baustein von vielen

Die Kosten-Nutzen-Rechnung spricht klar für den von uns gewählten Ansatz. Bei den aktuellen API-Preisen ist GPT-3 eine attraktive Alternative zu Eigenentwicklungen.

Klar ist aber auch: Die Integration der ChatGPT API war nur einer von vielen Bausteinen. Von der Bereitstellung der Daten bis zum Aufsetzen der Docker-Container: Um ein solches Projekt umzusetzen, braucht es viel Erfahrung in Machine Learning, ein eingespieltes Team und gute Kommunikation zwischen allen Projektbeteiligten.

Mein Dank für die erfolgreiche Umsetzung gilt deshalb nicht nur unseren fantastischen Data Scientists, sondern auch den beteiligten Projektmanager:innen, Frontend-Entwickler:innen und IT-Architekt:innen.

Was bedeutet das für Ihr

Unternehmen?

Was bedeutet das für Ihr Unternehmen?

Mit diesem Beitrag wollen wir Sie ermutigen. Der Einsatz von NLP-Anwendungen ist auch in Ihrem Unternehmen möglich. Und zwar schneller, als Sie denken!

Das glauben Sie nicht? Dann lassen Sie sich in einem persönlichen Telefonat überzeugen. Oder informieren Sie sich hier über Ihren MVP nach 100 Tagen.